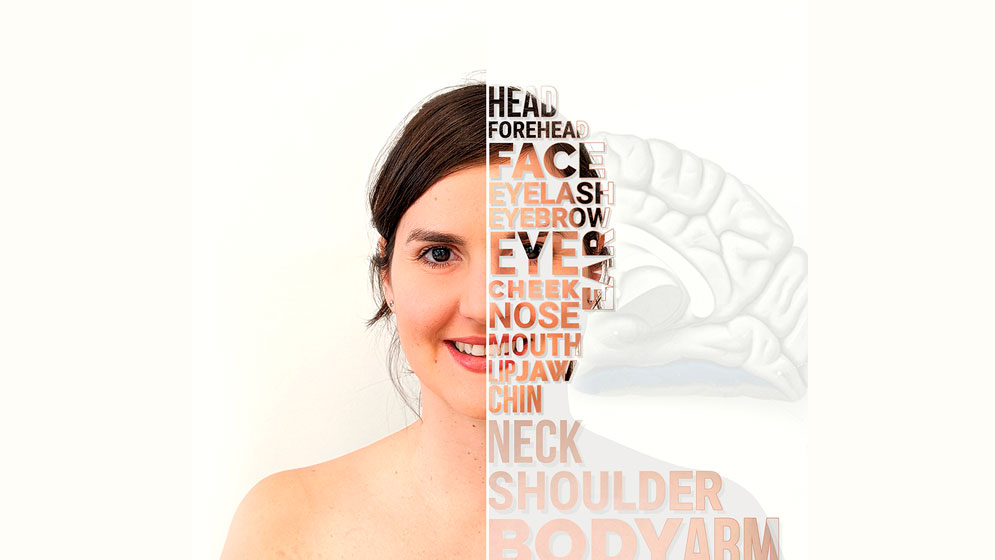

Los rostros de las palabras

19 agosto, 2020Investigadores argentinos demuestran que las palabras que nombran partes del rostro activan mecanismos sensoriomotores faciales antes que mecanismos semánticos

as palabras son manifestaciones del peculiar lenguaje de los seres humanos. Se dice que ellas evocan significados y que cuando se juntan dan lugar a conceptualizaciones abstractas que nos permiten comunicarnos. Pero, ¿de dónde surge el significado que nuestras mentes construyen al oír o ver una palabra?, ¿cómo hace el cerebro para comprender cabalmente un concepto?, ¿será que activa exclusivamente sus circuitos especializados para el lenguaje o hay algo más?

Quizás la punta del ovillo se encuentre por fuera de los circuitos clásicos del lenguaje, en particular, en los mecanismos faciales de nuestro cerebro, aquellos que se especializan en detectar y analizar rostros. Esta fue la conjetura de los científicos del CONICET Adolfo García, Agustín Ibáñez, Eugenia Hesse y Agustina Birba, que trabajan en el flamante Centro de Neurociencias Cognitivas de la Universidad de San Andrés. Teniendo en cuenta que el cerebro humano dispone de mecanismos muy específicos para procesar la información facial, es decir, circuitos que están ultra preparados para reconocer caras en una pequeña fracción de segundo y con mucha precisión, entonces –hipotetizaron los científicos– el cerebro tal vez sea capaz de construir el significado de un rostro en apenas milisegundos. Así surgió la pregunta de investigación: ¿Qué sucede si en lugar de ver un rostro, el cerebro lee una palabra que alude a caras o partes del rostro? ¿Procesará su significado con la misma velocidad y especificidad que cuando se enfrenta con un rostro real? ¿A qué mecanismos cerebrales acudirá?

La búsqueda por resolver estos interrogantes dio lugar a un estudio que fue publicado en la revista Cerebral Cortex. Este trabajo demostró que, en parte, “comprendemos el lenguaje porque nuestro cerebro reactiva las experiencias sensoriomotoras que evoca una palabra”, manifiesta García. “Si una palabra hace referencia a una parte del rostro, por ejemplo, el cerebro va a estar activando los mecanismos cerebrales de rostros. Para comprender una palabra, primero reactivamos las experiencias corporales que ésta suscita y luego accedemos a un concepto general”, ejemplifica.

De esta forma, el trabajo cuestiona la idea de que el significado se procesa únicamente mediante circuitos lingüísticos, cuya función es privativamente lingüística, y suma evidencia a otros trabajos previos. Además, ofrece evidencia inédita de que la activación de los circuitos sensoriomotores específicos es muy rápida y constitutiva del significado. “No es algo secundario o que aparece después de que se accedió al significado sino, por el contrario, es una piedra fundamental de la misma experiencia del significado”, expresa Birba.

El experimento

¿Cómo fue que llegaron a estas conclusiones? Los investigadores construyeron un sencillo experimento en el que los participantes debían leer las palabras que les iban apareciendo en una pantalla. Algunas eran palabras faciales (como ‘boca’, ‘nariz’, ‘ojo’, ‘frente’) y otras no faciales (‘pierna’, ‘pecho’, ‘brazo’). Al leerlas, tenían que decidir si se referían a partes del rostro, o no, mediante la presión de una tecla predefinida.

Mientras los participantes realizaban esta tarea, se registraba su actividad cerebral utilizando dos técnicas: en un primer experimento, mediante electroencefalografía (EEG) de alta densidad; y, en un segundo experimento, mediante de registros intracraneales (iEEG). En la primera, se colocan electrodos sobre el cuero cabelludo y se van midiendo los cambios temporales de la actividad eléctrica cerebral durante la ejecución de tareas específicas (en este caso, leer un estímulo lingüístico y clasificarlo). Al ser un método no invasivo, veinticinco personas sanas pudieron participar de esta prueba.

Para los registros intracraneales, por el contrario, se colocan los electrodos dentro del cerebro. Esta es una técnica invasiva, que solamente se utiliza con fines clínicos. “Estas intervenciones suelen ser muy efectivas para reducir epilepsias intratables que no responden a la medicación. Para identificar el foco epiléptico, se le colocan al paciente muchos electrodos en diferentes partes del cerebro”, explica Ibáñez. “En ciertos casos, es la única opción para mejorar la calidad de vida de los pacientes con epilepsia refractaria”, añade Hesse, y cuenta que cuando la operación se está llevando a cabo con fines quirúrgicos, el paciente se encuentra a la espera de que le venga algún episodio epiléptico para poder detectar donde este se genera.

La espera puede durar días. Durante ese tiempo, los científicos aprovechan esa circunstancia única para poder realizar estas investigaciones a las que pocos laboratorios científicos del mundo tienen acceso. “Tuvimos la gran oportunidad de estudiar a dos pacientes que tenían implantados electrodos al interior del giro fusiforme, una región muy especializada en el procesamiento de rostros. Entonces nos apuramos para construir una tarea que nos permitiera ver si esas regiones también responden rápidamente ante las palabras que evocan rostros”, relata García.

Ambas técnicas ofrecen una alta resolución temporal. Al ser tan precisas, sirven para saber exactamente (milisegundo a milisegundo) cómo se modula la actividad cerebral frente a un estímulo. “La resolución temporal precisa es muy importante porque aquí queremos saber qué es lo que pasa primero: si la información lingüística de una palabra es procesada primero por un área cerebral asociada al reconocimiento de rostro o por un área más asociada al lenguaje, y cuándo esto ocurre”, indica Ibáñez.

Por otro lado, también se midió la conectividad entre áreas cerebrales, lo que permite ver cómo se acoplan las diferentes áreas del cerebro. Por último, se utilizaron algoritmos de decoding, una técnica de aprendizaje de máquina que permite predecir una señal. “A la computadora le pedís que analice un pedacito de señal y que diga si la persona está procesando una palabra relacionada a ‘cara’ o a otra cosa”, indica Ibáñez. “La computadora aprende, gracias a la información que se le introduce, y realiza una clasificación. Esta información sirve, además, para predecir la actividad cerebral futura”.

Los resultados

“En nuestro estudio, descubrimos que las palabras que nombran ‘partes de la cara’ les echan mano a los circuitos de percepción facial de un modo crítico y muy rápido”, señala García. “La teoría tradicional dice que el cerebro tiene estructuras especializadas en donde unas procesan ‘rostros’ y otras procesan ‘lenguaje’”, añade Ibáñez. “Lo que pudimos constatar es que la experiencia sensoriomotora, de reconocimiento de rostros en este caso, juega un rol importante en el procesamiento semántico, es decir, en el significado de las palabras asociadas a rostros. Cuando uno escucha las palabras ‘ojos’, ‘cejas’, ‘boca’, el giro fusiforme (que se encarga del reconocimiento de rostros) se activa como si estuviese efectivamente viendo las caras. También se activan las redes semánticas, pero lo hacen más tarde”.

Además estas redes neuronales en apariencia diferentes, las semánticas y las faciales, se comunican entre sí. De hecho, descubrieron que, durante el procesamiento de palabras faciales, la conectividad entre ambos circuitos es mayor en la ventana de tiempo temprana, es decir, al inicio de la interacción, en los primeros 200 milisegundos (ms). “Cuando uno lee las palabras de cara, el diálogo entre circuitos faciales y los semánticos es mucho más intenso al principio que más tarde, entre los 200 y 400 ms”, dice Birba. “Esto también señala la rapidez y lo constitutivo que es el rol de los circuitos faciales en este caso”.

“Podríamos pensar que comprendemos el lenguaje mediante las redes neuronales lingüísticas clásicas y que después, más tardíamente, aparecen estas reactivaciones de experiencia, como algo secundario. Sin embargo, este estudio sugiere lo contrario: Estas reactivaciones no solamente existen sino que son fundacionales, son como la piedra fundamental, son parte de los pasos iniciales de cómo el cerebro construye significado a partir de una palabra”, manifiesta García y destaca que la activación de circuitos faciales a partir de palabras faciales se observa muy tempranamente, entre los 120 y 150 ms. Sin embargo, aclara García, “esto no significa que esos circuitos específicos faciales sean autosuficientes para el significado; más bien, lo que vemos es que desde muy temprano hay gran conectividad entre ambos circuitos (los faciales y los lingüísticos clásicos) durante el procesamiento semántico”.

Finalmente, con la técnica de decoding, los científicos entrenaron un algoritmo para que este indicara, palabra a palabra, si se trataba de una que aludía a partes del rostro o no en un momento específico. En este caso, observaron que se obtiene un 80 % de clasificación correcta cuando se analiza la actividad temprana del diálogo entre esas redes. En otras palabras, “en los primeros 200 ms, sólo considerando la dinámica cerebral de los sujetos, se puede saber exactamente si estaban procesando significados de rostros o de otras partes del cuerpo. En cambio, más tardíamente, ya no es tan claro el panorama. Hay mucha información crucial en la primera parte del procesamiento”, puntualiza Hesse.

En conclusión, este experimento muestra que, para comprender las palabras, el cerebro humano primero reactiva las experiencias corporales distintivas que éstas evocan (en este caso, información específica de los rostros) y luego acude a procesos conceptuales más generales. Estos resultados podrían tener diversas aplicaciones, desde educativas o pedagógicas hasta clínicas. Por ejemplo, ahora sabemos que las palabras que aluden a rostro se asocian de manera muy particular con el giro fusiforme y ya se sabía que una alteración en él puede generar prosopagnosia, una alteración neurológica que dificulta el reconocimiento de rostros (la famosa enfermedad que padece Brad Pitt). Entonces, una hipótesis posible es: ¿se pueden utilizar pruebas sencillas como ésta de leer palabras para ver si el giro fusiforme está funcionando bien?

Por otro lado, a nivel teórico, “nuestro estudio muestra que las áreas de procesamiento de rostro –que no son áreas del lenguaje– discriminan lingüísticamente”, expresa Ibáñez, “esto tiene un impacto relevante en la teorización de cómo funciona y se construye el significado. “Estamos rodeados de lenguaje”, dice García, “todo el día estamos escuchando, leyendo palabras, escribiendo, pensando con palabras. El lenguaje nos atraviesa, nos constituye. Por eso, saber cómo comprendemos las palabras es fundamental para entender uno de los principales sistemas que nos permiten comunicarnos desde que nos levantamos hasta que nos acostamos”.

Por Jorgelina Martínez Grau

Referencia bibliográfica:

Adolfo M García, Eugenia Hesse, Agustina Birba, Federico Adolfi, Ezequiel Mikulan, Miguel Martorell Caro, Agustín Petroni, Tristan A Bekinschtein, María del Carmen García, Walter Silva, Carlos Ciraolo, Esteban Vaucheret, Lucas Sedeño, Agustín Ibáñez (2020). Time to Face Language: Embodied Mechanisms Underpin the Inception of Face-Related Meanings in the Human Brain, Cerebral Cortex, https://doi.org/10.1093/cercor/bhaa178

Sobre investigación:

Adolfo M García. Investigador adjunto. UDESA

Eugenia Hesse. Becaria posdoctoral. INCYT

Agustina Birba. Becaria doctoral. INCYT

Agustín Ibáñez. Investigador independiente. UDESA